Google dio a conocer su nueva inteligencia artificial (IA) para generar archivos de audio a través de descripciones de texto. El nombre de esta herramienta es MusicLM y para su anuncio se mostró gran parte de sus formas de uso.

Para su funcionamiento el sistema está entrenado con un almacenamiento de 280.000 horas de melodías, desde ahí genera el contenido que es pedido por alguien basándose en la descripción de una frase, situación y muchas opciones. “MusicLM es un modelo que genera música de alta fidelidad a partir de descripciones de texto como ‘una melodía de violín relajante respaldada por un riff de guitarra distorsionado”, explican sus desarrolladores en la página oficial de la IA.

Pero además de crear canciones compuestas, también tiene la capacidad de crear piezas melódicas con silbidos y tarareando con el ritmo que se le pida.

Google anunció una herramienta con la que se pueden crear audios a través de descripciones de situaciones, pinturas, momentos y lugares.

Google anunció una herramienta con la que se pueden crear audios a través de descripciones de situaciones, pinturas, momentos y lugares.El potencial de esta inteligencia artificial

El anuncio de esta nueva herramienta está acompañado de varios ejemplos de cómo usarla, partiendo de que los límites están lo que a alguien se le pueda ocurrir porque una gran variedad de opciones de uso.

Las primeras partes de ideas relacionadas directamente con la música como, por ejemplo, crear una pieza de audio mezclando varios géneros como el reggaetón y la electrónica y que se le incluyera “un sonido espacial y de otro mundo”.

Pero también hay usos para crear la banda sonora de un videojuego árcade, dándole instrucciones precisas como que tenga un “ritmo rápido y optimista, con un pegadizo riff de guitarra eléctrica”.

Los ejemplos se amplían a situaciones más puntuales, como crear piezas para salir a correr, meditar, despertar o dar el 100% en una situación. Lo que amplía el rango de creatividad para combinar con otras ideas.

Google anunció una herramienta con la que se pueden crear audios a través de descripciones de situaciones, pinturas, momentos y lugares.

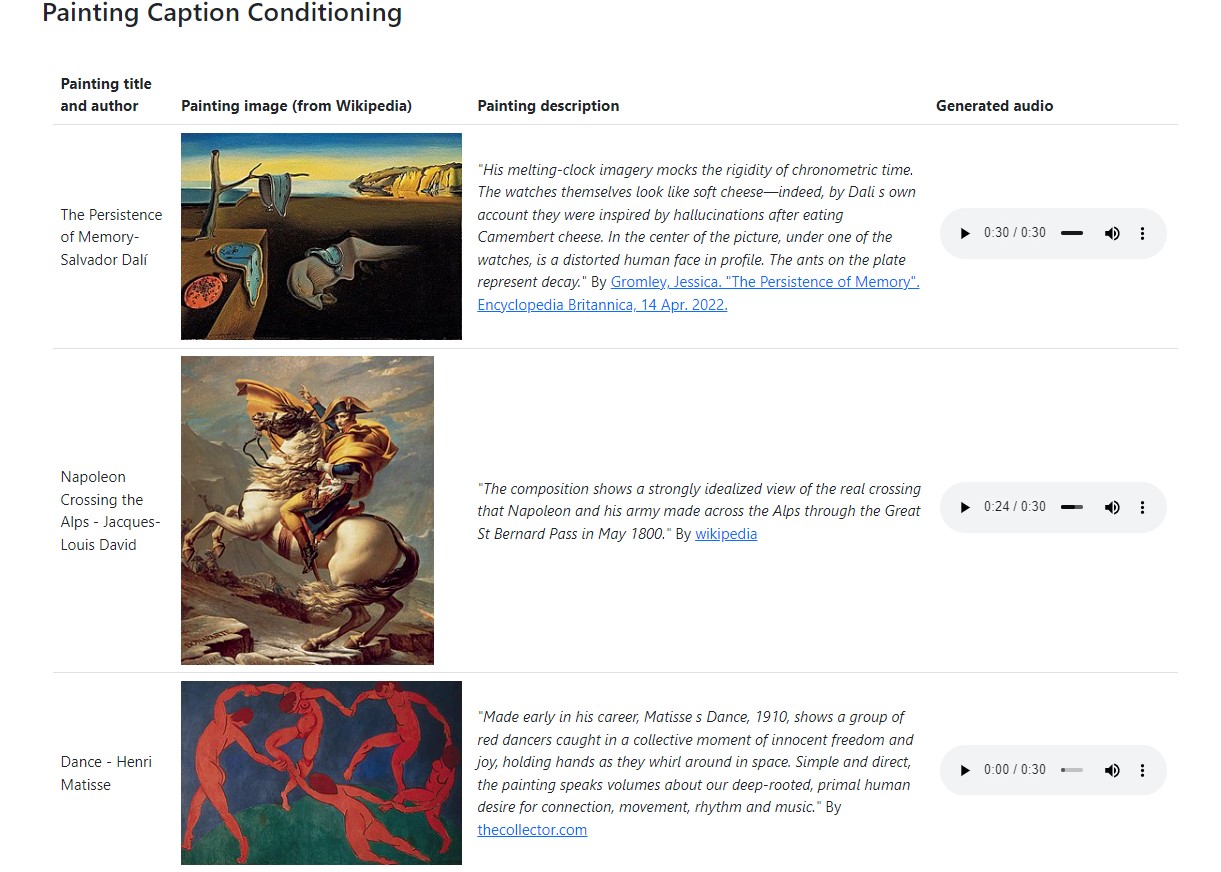

Google anunció una herramienta con la que se pueden crear audios a través de descripciones de situaciones, pinturas, momentos y lugares.Uno de los puntos más llamativos es la posibilidad de describir obras de arte. En el anuncio ponen varios ejemplos de cómo una pintura se puede convertir en música, basándose en la descripción de ella.

Una de ellas es The Persistence of Memory de Salvador Dalí, que la describen de la siguiente manera: “Sus imágenes de relojes que se derriten se burlan de la rigidez del tiempo cronométrico. Los propios relojes parecen queso blando; de hecho, según el propio Dalí, se inspiraron en alucinaciones después de comer queso Camembert. En el centro del cuadro, bajo uno de los relojes, hay un rostro humano distorsionado de perfil. Las hormigas del plato representan la descomposición”.

Y el resultado es una pieza musical tranquila, como si estuviera en la playa en medio de un viaje y con tonadas suaves.

Un ejemplo que repiten con icónicas obras como Napoleon Crossing the Alps de Jacques-Louis David, Dance de Henri Matisse y The Scream de Edvard Munch.

Pero las posibilidades son infinitas porque generan audios que representan lo que sonaría en un lugar, el acorde de un género musical, diferentes décadas o niveles de experiencia de un músico.

Finalmente, pusieron varios ejemplos de cómo una misma solicitud puede crear diferentes piezas, gracias a la gran cantidad de horas de música con las que está diseñada esta inteligencia artificial.

Por ahora esta herramienta no está disponible para todos los usuarios y, según TechCrunch, Google no tiene planeado lanzarla en el corto plazo debido a los retos que esto representa por temas de derechos de autor y copyright.

Gran parte de esto se dio porque los investigadores encontraron que por lo menos el 1% de las piezas generadas contaban inspiración de música ya existente.

“Descubrimos que solo una pequeña fracción de los ejemplos se memorizaba con exactitud, mientras que en el 1% identificábamos una coincidencia aproximada. Insistimos en la necesidad de seguir trabajando en el futuro para hacer frente a los riesgos asociados a la generación de música”, afirmaron.